چگونه «انسان بودن» را در فعالیتهای رسانههای اجتماعی آزمایش میکنید، و آیا واقعا راهی وجود دارد که بتوانید این کار را بدون کلاهبرداری توسط کلاهبرداران انجام دهید؟

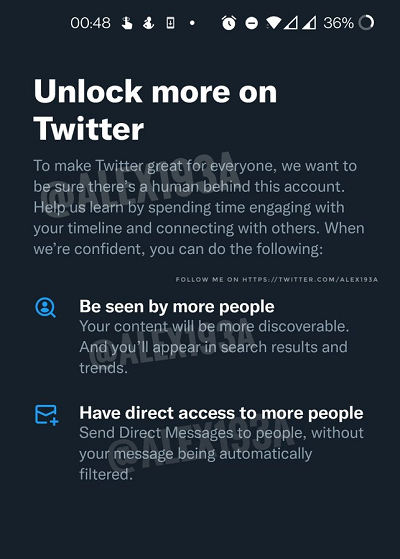

به نظر می رسد که توییتر معتقد است که می تواند، با این پیام جدید در کد پشتیبان برنامه کشف شده است.

همانطور که در این اعلان مشاهده می کنید، توسط محقق برنامه کشف شده است الکساندر پالوزیتوییتر روی فرآیند جدیدی کار میکند که ظاهراً کاربران را از استفاده از عناصر خاصی از برنامه تا زمانی که بتوانند ثابت کنند واقعاً انسان هستند محدود میکند – «با صرف زمان برای درگیر شدن با خط زمانی شما و برقراری ارتباط با دیگران».

اگر در آزمون انسانی موفق شوید، دید بهتری از توییت خواهید دید، در حالی که به ابزارهای DM آن نیز دسترسی کامل خواهید داشت.

اما باز هم، آنچه که این آزمایش انسانی ممکن است به همراه داشته باشد، می تواند پیچیده باشد. یک شخص چه اقداماتی می تواند انجام دهد که یک ربات نمی تواند انجام دهد، و چگونه ممکن است توییتر بتواند چنین اقداماتی را، به نظر شما، به روشی خودکار اندازه گیری کند؟

شما فرض میکنید که توییتر نمیتواند چنین چیزی را فاش کند، زیرا قطعاً آن را به روی کلاهبرداران باز میکند. اما کار زیادی هم وجود ندارد که یک کاربر معمولی بتواند کاری که یک ربات نمی تواند انجام دهد. میتوانید یک حساب ربات را برای دنبال کردن/لغو فالو کردن افراد، توئیت مجدد دیگران، ارسال توییت برنامهریزی کنید.

به نظر می رسد تعیین دقیق فعالیت ربات بسیار دشوار باشد – اما ایلان ماسک، رئیس جدید توییتر مصمم است با مشکل ربات در این برنامه مبارزه کند، مشکلی که به قدری بد است که در یک مرحله، ماسک به دنبال پایان دادن به قرارداد تصاحب توییتر خود بود، به دلیل اینکه این پلتفرم مملو از حساب های ربات است.

در ماه اوت، تیم حقوقی ماسک درخواستی را ارائه کرد که مدعی شد 27 درصد از تعداد mDAU توییتر – یا کمی بیش از 64 میلیون کاربر – در واقع ربات بودند، در حالی که تنها 7 درصد از کاربران واقعی توییتر اکثر تبلیغات آن را مشاهده می کردند.

توییتر مدتهاست که بر این باور است که رباتها/هرزنامهها تنها 5 درصد از تعداد کاربرانش را تشکیل میدهند، اما تیم ماسک روششناسی این فرآیند را زیر سوال برده بود، زیرا توییتر فقط یک نمونه تصادفی از 9 هزار حساب را در هر دوره گزارش اندازهگیری میکرد.

با این حال، از زمان تصدی این سمت، ماسک تعداد کاربران توییتر را تبلیغ کرده است که به گفته ماسک، اکنون در بالاترین حد خود قرار دارد. اما طبق تخمین تیم خودش، به نظر میرسد که رباتها همچنان بخش قابلتوجهی از این پروفایلها را تشکیل میدهند، به همین دلیل است که تیم توییتر 2.0 مایل است اقدامات جدیدی را برای حذف رباتها و ارائه اطمینان بیشتر به شرکای تبلیغاتی اجرا کند. و کاربران

این شامل تشخیص و حذف ربات بهبود یافته است (ماسک می گوید که توییتر تعداد زیادی حساب ربات را در هفته گذشته حذف کرد، و از آن زمان تاکنون بوده است آستانه تشخیص ربات خود را کاهش داد پس از حذف تعداد زیادی حساب غیر ربات)، در حالی که طرح راستیآزمایی 8 دلاری جدید توییتر را نیز شامل میشود، که چیزی را که ماسک «تأیید پرداخت» مینامد را اجرا میکند – یعنی رباتها و کلاهبرداران برای ثبت حسابهای خود پولی پرداخت نمیکنند. این برنامه همچنین به طور موثر انسان های واقعی را برجسته می کند.

و اگر به اندازه کافی جذب شود، این می تواند گام کلیدی دیگری در مبارزه با ربات ها باشد، با اکثریت کاربران واقعی در نهایت یک چک تایید شده را نمایش می دهند. احتمال ثبت نام تعداد زیادی از افراد برای تبدیل این موضوع به یک بررسی قابل قبول در این زمینه مشکوک است، اما از نظر تئوری، این می تواند عنصر دیگری در فشرده سازی ربات توییتر باشد.

این یافته همچنین زمانی به دست آمد که توییتر تأیید کرد که پس از جمع آوری کارکنان اخیر خود که شامل هزاران نفر از تیم های نظارتی خود بود، اکنون به شدت به سمت خودکارسازی به سمت محتوای تعدیل گرایش پیدا کرده است.

به منظور مدیریت بیشتر، با نظارت کمتر انسانی، بررسی دستی پروندهها توسط توییتر کاهش مییابد، که باعث شده است محتوای بیشتری را در بخشهای خاص حتی سریعتر حذف کند، از جمله، طبق گزارشها، مطالب استثمار کودکان.

به گفته Vice پلتفرم، اتکای بیشتر به اتوماسیون ناگزیر به گزارشها و اقدامات نادرست بیشتری نیز میشود، اما توییتر اکنون با احتیاط اشتباه میکند، به گفته معاون پلتفرم، این تیم قدرت بیشتری دارد تا «سریع حرکت کند و تا حد امکان تهاجمی باشد». رئیس اعتماد و ایمنی الا اروین.

که می تواند چیز خوبی باشد. این امکان وجود دارد که با پیشرفتهایی در تشخیص خودکار، مداخله دستی کمتری در حال حاضر مورد نیاز باشد، که میتواند این مسیر را به مسیری قابل دوامتر از زمانهای گذشته تبدیل کند. اما زمان نشان خواهد داد، و تا زمانی که اطلاعات دقیقی در مورد موارد توهینآمیز نداشته باشیم، تأثیرات کامل رویکرد جدید توییتر را نمیدانیم. اکنون که شرکت در مالکیت خصوصی است و موظف نیست در این مورد به بازار گزارش دهد، ممکن است هرگز به آن دست یابیم.

گزارشهای شخص ثالث حاکی از آن است که از زمانی که ماسک مدیریت این اپلیکیشن را به دست گرفت، بروز سخنان تنفرآمیز به طور قابل توجهی افزایش یافته است، در حالی که کارشناسان ایمنی کودکان ادعا میکنند که تغییرات اعمالشده توسط تیم ماسک تاکنون تأثیر کمی بر رسیدگی به این عنصر داشته است.

با این حال، ماسک امیدوار است که با افزودن سطح دیگری از مسئولیتپذیری، از طریق تأیید انسانی، تیم او را بهتر قادر به مقابله با چنین مواردی کند، اما باز هم باید دید که سیستمهای آن دقیقاً چگونه میتوانند «انسان بودن» را اندازهگیری کنند و چقدر مؤثر هستند. که ممکن است در خفه کردن فعالیت ربات باشد.

در تئوری، همه این گزینههای مختلف میتوانند کار کنند، اما تاریخچه برنامههای اجتماعی و تعدیل محتوا نشان میدهد که این کار آسانی نیست، و هیچ راهحل منحصر به فردی برای رسیدگی به مسائل و عناصر کلیدی در دست وجود ندارد.

که تیم جدید توییتر با اجرای طیف وسیعی از اقدامات به آن اذعان میکند – و جالب است که ببینیم آیا واقعاً راهی برای مبارزه با این نگرانیهای کلیدی بدون استفاده از تیپهای تیمهای اعتدال وجود دارد که وظیفه مرتبسازی آنها را بر عهده دارند. بدترین انسانیت هر روز

اجرای یک آزمایش «انسانی» دشوار خواهد بود، اما شاید، از طریق ترکیبی از بینشهای شرکتها و همکاران مختلف ماسک، چیزی وجود داشته باشد که بتوان به این ترکیب اضافه کرد تا سیستمهای موجود را ارتقا دهد.